今やデータサイエンスは技術革新のさまざまな分野で活用されていますが、人とコンピュ ータをつなぐヒューマンインタフェースの開発もその一つ。なかでも、医療や心理学、観光、広告など多岐にわたる分野で活躍が期待される「視線によるヒューマンインタフェース」を開発するため、ソフト面が注目されがちなデータサイエンスにおいて、データ収集の場や製造現場での活用にも関わるハード面にも力を注ぐ廣江助教に、研究内容や今後取り組みたいテーマについてお話を伺いました。

専門分野について教えてください。

メインの研究は、ヒューマンインタフェース分野です。

ヒューマンインタフェースというのは、人とコンピュータの間に入る機械のことで、パソコンだったら、キーボードやディスプレイ、タッチパネルなどがそれに当たります。

そのなかで、視線による入力、視線によるインタフェースの研究をしています。また、視線を計測するときに眼球の画像を処理したりするので、画像処理や機械学習(※1)も関連した分野になります。視線によるインタフェースを構築するために、視線計測装置の開発と装置を使った分析を行っています。

(※1)コンピュータに大量のデータを読み込ませ、データの背景にあるルールやパターンを発見させる方法。

装置の開発については、特にキャリブレーションの自動化をめざしています。キャリブレーションとは、人によって目には個人差があるため、その違いを考慮して視線を測定するために必要な調整(校正)作業のことです。従来の視線計測装置では、使用を始める前に「ここを見てください」というキャリブレーションを行ってから「では、使ってください」という流れになります。ですが、私は、このキャリブレーションが何も意識せずに行われて、装置の前に座ったらすぐに使える状態にするというアルゴリズムの開発を行っています。

機械設計というよりは、視線計測に使う理論や計算方法を作ることで、新たな視線計測装置を開発していると言えます。開発したアルゴリズムの検証は市販の計測装置で行えないため、産業用カメラを動かしたり、回路設計などのハード面の開発も行います。

▲キャリブレーションの様子

この視線計測技術を、本格的に社会実装したいと思っています。例えば、特に小さな子どもに「ここを見てね」と言ってもキャリブレーションに協力してもらうことは難しいのですが、この技術があれば、子どもの視線だけでなく、動物の視線さえも計測できるようになるかもしれません。

また、共同研究している先生の研究によると、子どもの眼球運動が学習能力に影響がある、という話もあるので、眼球運動を測ったり、眼球運動のトレーニングを行ったりするときにも役に立つのではないかと考えています。

視線計測の仕組みについて、詳しく教えてください。

まず代表的な視線計測装置には、眼鏡のような接触型と、置いて使う設置型の 2 つがあります。どちらもカメラを使って眼球の画像を撮り、その画像から視線を測ります。私の研究では設置型を使っているのですが、被験者がすぐに交代できるという理由と、顔に何も触れていないほうが違和感なく実験できるという理由からです。

設置型の視線計測手法には、眼球の動きをモデル化してシミュレートするモデルベースと、機械学習を使って「こういう眼球もしくは顔の状態のときはこちらを見ているはず」という推測を立てて行うアピアランスベースがあります。アピアランスベースの手法はカラーのカメラ 1 つあれば視線を推定できるので手軽なのですが、精度があまり良くなりません。

なので、私はモデルベースの手法の中で精度が良い、赤外線カメラ 2 台と赤外線光源 2 個以上を使う手法に注目して研究を行っています。

カメラが 2 台あれば 2 つの平面が撮れるので、眼球の位置が 3 次元的に測定できます。

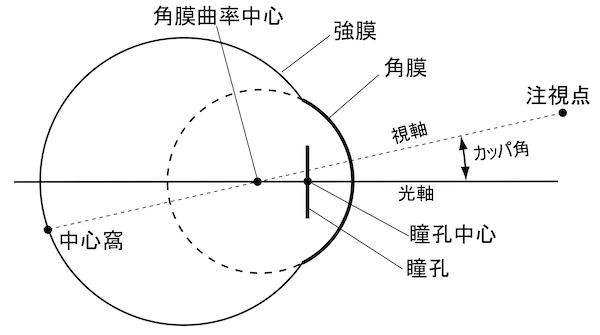

光源の光が眼球の表面で反射している位置と瞳孔の位置を 3 次元的に捉えると、黒目の中心、つまり角膜の中心と瞳孔の中心の位置が求められます。角膜の中心と瞳孔の中心の位置、この 2 点を結んだ線が眼球の「光軸」です。それに対して、見ているものと眼球の奥にある中心窩とをつなぐ線が「視線」です。

光軸と視線とは少しずれており、このずれる度合いは人によって違います。私が開発した 3D モデルの視線計測装置では、このずれを測ることでキャリブレーションを行います。

<図1 角膜を球面とモデル化した眼球モデル>

ちなみに、大阪成蹊大学のオープンキャンパスでは、眼鏡の形をした視線計測装置(アイトラッカー)を体験できるプログラムも実施しています。

▲視線計測装置(アイトラッカー)を使ったデモンストレーションの様子

この視線計測装置の研究で、一番の特徴は何ですか?

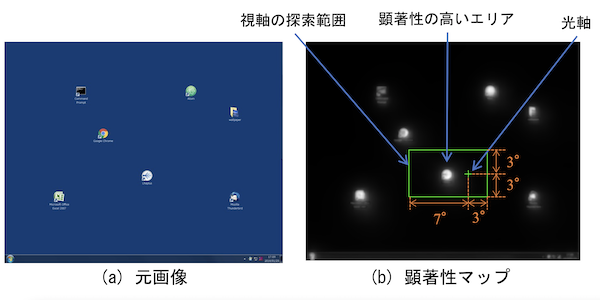

「顕著性マップ」を使ってキャリブレーションをするという理論を見つけたことです。

人が画面を見たときに目が行きそうな場所を計算、予測するための顕著性マップという手法があります。例えば、画面の中に真っ赤な車があればそこに目が行くはずだと推定する手法です。この顕著性マップの特性を利用して、そこに目が行っているはずだと機械が計算した視線の位置と、眼球の光軸周辺の位置の差を計算することでずれを測る、ざっくり言うとそんな理論です。

データを何パターンも集めて分析することで視線の位置がわかってくるので、その平均をとることで安定して精度良くキャリブレーションを行えます。

<図2 顕著性の高い領域の探索範囲の限定>

基本的な顕著性マップは、画面の中に赤いものがあったり、一部だけすごく明るかったり、突然変わった建物があったり、といった単純なものでした。しかし、最近の顕著性マップは、「こういう絵のときは視線がここへ行く」というのが機械学習で予測できるようになっています。

そういった機械学習の発展によって性能が向上した顕著性マップを使うことで、より精度の高い計測を行えるようになりました。このキャリブレーションの手法はこれまでにはなかったものなので、特許も取得しています。

視線計測でどういったことができるようになるのでしょうか?

例えば博物館で、ある展示物を見ているだけで、その説明が表示されて教えてもらえたり、街なかにあるモニターを見ている人が知らない間にキャリブレーションされていて、その人がどこを見ているかがわかったりするかもしれません。世の中にはすでに VR などもあるので、今言ったような技術は現実になっていそうなのに、意外とできていないんですよね。

ここ最近では、AI が何かと注目を集めていますが、私自身は 、仕事を奪われる、と怖がるのではなく、AI という面白いことができる道具が増えたのだから、それを使ってもっと面白い研究をしようよ、と思っています。

視線計測装置自体は、長く研究されているテーマです。しかし、社会実装については ALS (筋萎縮性側索硬化症)の方が使っているものはありますが、一般的に使えそうなものはまだありません。音声入力は一斉に広まったのに、視線入力はいつになったら普及するんだろう、と思っています。口を動かすより、見るだけでテレビのチャンネルが変わったりしてくれたらラクですよね。

研究の難しいところや楽しいところについて教えてください。

私の場合、同じ研究をしている人がほとんどいない分野の研究をしているので、情報がなかったり、手探り状態のことが多かったりするのが難しいところです。また、この技術を使いたかったら、このプログラミング言語を習得するしかないといったようなことが発生したり、私は普段は Python(※2)を使っているのですが、たまに違う言語で書かれているものを Python に直さないといけなかったりするので、そういった点が大変だと思います。あとは、仲間が少ないところ(笑)。ライバルが少ないという点では良いことでもあるのですが……。

(※2)AI やアプリ開発など、さまざまな分野に対応できる汎用性の高いプログラミング言語。

一方で、楽しいところは、誰も知らないことがわかるようになるという点です。実験や分析でわかったことは、論文を発表するまでは、本当に世界で自分しか知らないじゃないですか。学生のときは先生と一緒に研究をしていましたが、そのときでも、先生に結果を報告するまでは世界で自分しか知らないんです。そういうところは、けっこうワクワクしますね。

子どもの頃から理工系分野に興味があったのでしょうか?

子どもの頃から、「ロボットってかっこいいな、ロボットをつくりたいな」といった感じで、ものづくりに興味がありました。

大学では、ものづくりの中でもパッと見て一番大きな「船舶」のものづくりに関係する海事科学を専攻しました。材料工学や電子工学の勉強が多く、プログラミングなどのシステムの授業はあまりありませんでした。でも、研究室を選ぶときに、その頃はロボットでも特にソフト面に興味があったので、ハードウエアとソフトウエアの両方が学べる研究室を探して、たまたまあったのが視線計測の研究を行っている研究室でした。でも、その研究が面白くて博士号を取得するまでに至りました。

大学院を修了後は、同じ大学の医学研究科で、世間一般で言われるようなデータサイエンスに携わっていました。医療ビッグデータを使って、高齢者の健康予測モデルを開発する研究です。この研究では、まずデータをきれいにして分析できる状況にする作業から、分析作業そのものまでの、いわゆるデータエンジニアリングとデータサイエンスの両方を担当しました。産学官連携の研究で、日立製作所と一緒に行っているのですが、現在も継続して研究員としてプロジェクトに参加しています。

今後の研究について教えてください。

一つは、認知症を視線で検出するという研究です。

認知症の程度まで検出するのは難しいのですが、「疑いがあるので病院へ行くのを勧める」ぐらいの症状を視線計測装置で検出するという研究を行っています。

もう一つは始めたばかりの研究なのですが、内視鏡を使う医師の視線の研究です。

内視鏡を使うときは、基本的に画面だけを見ながら手を動かしますよね。そのときに医師がどこを見ているのか、その視線を計測することで、内視鏡医をめざす方のトレーニングに使えるようなシステムを作りたいと考えています。また、内視鏡で撮影した画像を処理する際に、悪い部分を見つける支援をしてくれる AI があるのですが、その発展にも結びつくかもしれません。

他にも、矯正歯科医が写真や顔を見て診断する際、どこをどのように見ているのかを明らかにするために、視線のデータを集めたことがあります。こういった医工連携分野での研究にも、視線計測技術をもっと活用していきたいです。

何かの技術を伝えたり教育したりする際に、これまでは口で言われても感覚でしかわからなかったものを、視線データの分析によって可視化できるのでは、と考えています。

データサイエンスに興味がある学生にメッセージをお願いします!

「好奇心を優先する」というのが一番のキーワードですね。

大学を選ぶときに偏差値を重視することもあると思いますが、オープンキャンパスに来る学生に私は「自分が一番やりたい研究ができそうな先生がいる大学を探してみたら」とアドバイスしています。社会に出ると、大学の名前や偏差値ではなく、大学で何をしたか、どんな研究をしたかのほうが大事だと思うからです。何より、自分が面白いと思ったことを研究したほうが飽きることなく続けられますし。

特にデータサイエンスの道に進めば、データを活用できる人材は世の中のあらゆる分野で求められているので就職活動の武器になるでしょうし、将来の可能性も広がります。

大阪成蹊大学のデータサイエンス学部は開設されて間もないですが、有名国立大学などで活躍されていた先生方が多いので、やりたい研究が見つかりやすい環境だと思います。すごい先生ばかりなので、一見、近寄りがたく感じるかもしれませんが、じつは気さくな先生が多いんですよ。